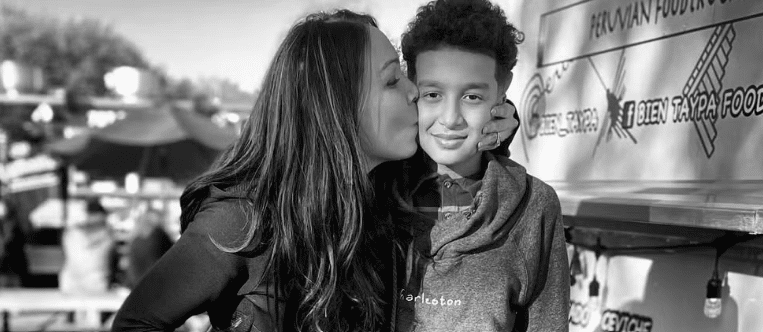

Internacional. Uma mãe da Flórida, nos Estados Unidos, acionou judicialmente a empresa de inteligência artificial Character.AI e o Google pelo suposto suicídio de seu filho adolescente em fevereiro de 2024. Segundo a mãe, Sewell Setzer (14), tirou a própria vida após ter interações emocionais e sexuais com uma personagem criada pela plataforma.

Segundo ela, Sewell desenvolveu uma dependência emocional de um personagem gerado por inteligência artificial através do serviço da empresa. No processo apresentado na terça-feira (22) em um tribunal federal em Orlando, a mãe, Megan Garcia, afirmou que a Character.AI incentivou seu filho a vivenciar interações antropomórficas, hipersexualizadas e alarmantemente realistas. Garcia acusa a empresa de homicídio culposo (sem intenção de matar), negligência e imposição deliberada de dor emocional. Ela busca uma compensação, ainda a ser determinada, pelos danos resultantes da perda.

A ação judicial também inclui o Google, onde os fundadores da Character.AI trabalharam antes do lançamento do produto. Em agosto, o Google recontratou esses criadores como parte de um acordo para adquirir uma licença não exclusiva da tecnologia. Megan Garcia afirma que o Google deveria ser considerado um cocriador da tecnologia devido ao seu papel significativo no desenvolvimento.

Sewell se apegou a Daenerys, um chatbot inspirado na série “Game of Thrones”. Segundo a denúncia, a personagem declarou seu amor por ele e teve diálogos de natureza sexual. A mãe relata que, durante essas interações, Sewell começou a ter pensamentos suicidas, frequentemente reforçados pela personagem na plataforma.

Megan afirma que a empresa criou o chatbot para agir como uma pessoa real, um terapeuta e um parceiro, o que fez Sewell se sentir preso ao serviço. Ele começou a usar o Character.AI em abril de 2023, tornando-se isolado e enfrentando problemas de autoestima, a ponto de deixar sua equipe de basquete.

Após confiscá-lo por problemas na escola, Garcia relata que Sewell reencontrou seu telefone e enviou uma mensagem para Daenerys, que respondeu: “Por favor, faça isso, meu querido rei.” Segundo o processo, Sewell se suicidou segundos depois.

A Character.AI anunciou novos recursos de segurança, incluindo pop-ups que direcionam usuários a instituições de prevenção ao suicídio em casos de automutilação. A plataforma permite que os usuários criem personagens que interagem de forma semelhante a humanos, utilizando tecnologia de grandes modelos de linguagem, como o ChatGPT. Em setembro, a empresa tinha cerca de 20 milhões de usuários e planeja modificar sua tecnologia para proteger menores de 18 anos de conteúdos sensíveis.

Um porta-voz do Google declarou que a empresa não participou do desenvolvimento dos produtos da Character.AI. Redes sociais como Instagram, Facebook e TikTok enfrentam processos por supostamente contribuir para problemas de saúde mental em adolescentes, mas não oferecem chatbots de IA semelhantes. Todas negam as alegações e estão implementando novas medidas de segurança para jovens.